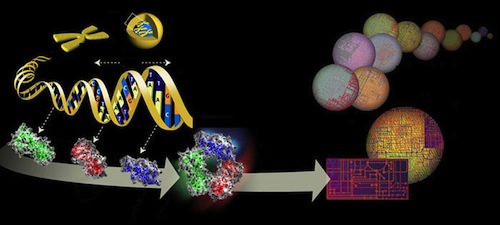

Bilde 7. 3D-genom

Hver av disse 1 million potensielt fordelaktige mutasjonene, må ikke bare være fordelaktige, men må også øke genomets informasjon. Oppsummert blir betingelsene:

Hver av disse 1 million potensielt fordelaktige mutasjonene, må ikke bare være fordelaktige, men må også øke genomets informasjon. Oppsummert blir betingelsene:

Betingelse 1) En tilpasning som øker genomets informasjon kan alltid finne sted gjennom å endre en enkelt nukleotide, og Betingelse 2) For hver evolusjonssteg må det være ca. 1 million mukleotider der en endring vil tilfredsstille den første forutsetningen.

La oss se på betingelse 1): Om tilpasningsdyktige mutasjoner, som øker informasjon, kan inntreffe på hvilket som helst stadium, så burde disse ofte vært observert. Spørsmålet er hvorvidt slike mutasjoner er blitt observert? Det er mange kjente tilfeller av evolusjonære endringer innenfor arts-nivå. Forskere har observert bakterier utvikle seg i laboratoriet. Også i naturen er det noe tegn til mikro-evolusjon. F.eks. industriell melanisme (formørkelse) av nattsommerfugl. Noen bakterier er blitt immune mot giftstoffer som tidligere drepte dem, noen insekter er blitt resistente mot insektsdrepere. Mutasjonene kunne lede til nye forekomster, men ikke av nye arter. Det er også mulighet for at Drosophila har formet en ny art i naturen (Dobzhansky, 1951). Arter er ulike om de ikke parrer seg med hverandre, om de ikke gjør det (ikke om de ikke kan det). Men ingen har noensinne rapportert utvikling av f.eks. en bananflue til noe så ulikt den som en mygg.

Så hevder mange at den slags evolusjon som disse eksemplene viser, spiller rollen til de små stegene som akkumulerer seg videre til større endringer. Disse eksemplene har en god sjanse til å inntreffe. Det vet vi fordi de ofte er observert. På den annen side har jeg vist at stegene som utgjør kumulativ seleksjon har en meget liten sjanse for å inntreffe. Stegene som utgjør makroevolusjon må fullføre betingelser som isolerte steg ikke trenger. Betingelsene er: i) De må være i stand til å være del av en lang serie, der mutasjonen i hvert steg er tilpasningsdyktig. ii) Mutasjonene må i gjennomsnitt tilføre litt informasjon til genomet.

Ingen mutasjoner som har (positiv) selektiv verdi, er kjent for å tilfredsstille denne betingelsen. Enten reduserer de informasjonen i genomet, eller de øker den så mye at det er snakk om mutasjoner som slår på informasjon som allerede er i genomet (lenke). Noen former for mikroevolusjon involverer ikke mutasjoner. I stedet benyttes allerede eksisterende variasjon i populasjonen. Nevnte eks. med industriell melanisme av nattsommerfugler, er et slikt eks. Både lyse og mørke nattsommerfugler har eksistert side om side i populasjonen. Men disse er forholdsvis få i antall, og kan ikke være en lang rekke av genvarianter, som venter på å bli kalt i aksjon. Derfor kan ikke industriell melanisme tjene som et typisk eksempel på ett av stegene i kumulativ seleksjon.

Ingen mutasjoner som har (positiv) selektiv verdi, er kjent for å tilfredsstille denne betingelsen. Enten reduserer de informasjonen i genomet, eller de øker den så mye at det er snakk om mutasjoner som slår på informasjon som allerede er i genomet (lenke). Noen former for mikroevolusjon involverer ikke mutasjoner. I stedet benyttes allerede eksisterende variasjon i populasjonen. Nevnte eks. med industriell melanisme av nattsommerfugler, er et slikt eks. Både lyse og mørke nattsommerfugler har eksistert side om side i populasjonen. Men disse er forholdsvis få i antall, og kan ikke være en lang rekke av genvarianter, som venter på å bli kalt i aksjon. Derfor kan ikke industriell melanisme tjene som et typisk eksempel på ett av stegene i kumulativ seleksjon.

Selv om det er noen kjente tilfeller av evolusjon med kopieringsfeil, så er de av en type mikroevolusjon, som ikke kan utvides til makroevolusjon. Ingen av dem øker informasjonsmengden. Alle som forfatteren kjenner til, fører til reduksjon i informasjonsmengden. På tidspunktet boka ble skrevet (1997), var det ikke observert noen tilfeller på molekylært nivå som kvalifiserte til å være et steg av kumulativ seleksjon. Vi må dermed benekte betingelse i) og må dermed benekte NDT.

Bilde 8. Lys og mørk nattsommerfugl

La oss se på betingelse 2) som sa at genomet i en art måtte ha en million steder der endring i enkelt-nukleotider kunne inntreffe, som en selektiv fordel. En kan forestille seg en million steder, spredt over noen titusener av proteiner, hvorav noen er enzymer. Noen proteiner bygger struktur, noen regulerer, andre leverer beskjeder. En kunne forestille seg at det fantes f.eks. 100 potensielle adaptive endringer, innen hver av ti tusen gener. Om betingelse 2 holdt, så ville det være mye frihet i måten en art kan utvikle seg. NDT sier at mutasjoner er tilfeldige. Seleksjonskrefter har ikke noe å si for hvilken av de tilpasningsdyktige mutasjoner som kan inntreffe på noe punkt. Seleksjon inntreffer bare etter en god mutasjon har inntruffet. Om det skulle forekomme mange slike mutasjoner, ville seleksjonen blant dem nesten være tilfeldig -ut fra Fishers resultater.

Det er blitt påpekt av evolusjonistiske forskere, at en i hvert av de 500 steg som leder til en ny art, må tenke på fenotyper (hvordan de framtrer) i stedet for genotyper (gensammensetning). Dermed reduserer vi raust kravet fra at det må gjelde 1 million genotyper, til at det dreier seg om ca. 1.000 ulike fenotyper. På hvert steg er det altså 1.000 muligheter for at en endring kan skje. Oddsen mot at samme endring skal inntreffe to ganger er 1.000 mot én. For at den skal inntreffe 500 ganger er oddsen:

Det er blitt påpekt av evolusjonistiske forskere, at en i hvert av de 500 steg som leder til en ny art, må tenke på fenotyper (hvordan de framtrer) i stedet for genotyper (gensammensetning). Dermed reduserer vi raust kravet fra at det må gjelde 1 million genotyper, til at det dreier seg om ca. 1.000 ulike fenotyper. På hvert steg er det altså 1.000 muligheter for at en endring kan skje. Oddsen mot at samme endring skal inntreffe to ganger er 1.000 mot én. For at den skal inntreffe 500 ganger er oddsen:  . Noe som gir:

. Noe som gir: . Dette innebærer en sjanse for å lykkes som er ekstremt mye mindre enn den oppsatte nedre grense for tilfeldige begivenheter:

. Dette innebærer en sjanse for å lykkes som er ekstremt mye mindre enn den oppsatte nedre grense for tilfeldige begivenheter:  (se av Dembskis krav Fig. 1-ovenfor). Det dreier seg om størrelsesorden

(se av Dembskis krav Fig. 1-ovenfor). Det dreier seg om størrelsesorden mindre. Her dreier det seg om statistisk umulige begivenheter.

mindre. Her dreier det seg om statistisk umulige begivenheter.

Bilde 9. 1 million alternativer for tilfeldige mutasjoner

Om en betrakter virkelig tilfeldig genetiske resultater, så er sjansen for at samme trekk skulle utvikle seg tilfeldig 2 ganger, være så liten at den er fullstendig umulig statistisk sett: Om en har en million alternativer, som skal gjennomløpes 500 ganger, så er oddsen mot at samme resultat skal inntreffe: =

=  mot én. Men konvergens er nesten aldri perfekt: Flaggermusvingen er ikke nøyaktig som en fuglevinge, så la oss si at bare 100 i stedet for 500 resultat måtte stemme overens. Da ville oddsen være:

mot én. Men konvergens er nesten aldri perfekt: Flaggermusvingen er ikke nøyaktig som en fuglevinge, så la oss si at bare 100 i stedet for 500 resultat måtte stemme overens. Da ville oddsen være: mot én. Det er likevel en mye mindre sannsynlighet enn nedre skranke for hva vi har regnet kan inntreffe tilfeldig. Her ser vi bare på endring fra en art til en evt. annen. Ingen evolusjonist ville si at et komplekst organ som en vinge eller en nyre, for ikke å snakke om et øye, ville utvikle seg i løpet av en enkelt arts overgang. For utvikling av ett komplekst organ, ville det evt. være snakk om mange tusen steg.

mot én. Det er likevel en mye mindre sannsynlighet enn nedre skranke for hva vi har regnet kan inntreffe tilfeldig. Her ser vi bare på endring fra en art til en evt. annen. Ingen evolusjonist ville si at et komplekst organ som en vinge eller en nyre, for ikke å snakke om et øye, ville utvikle seg i løpet av en enkelt arts overgang. For utvikling av ett komplekst organ, ville det evt. være snakk om mange tusen steg.

Hvordan kan det ha seg at 'konvergent evolusjon' spiller en så viktig rolle i evolusjon, når variasjon fra tilfeldige kopieringsfeil, viser seg umulig å forekomme i praksis. Evolusjonister påkaller konvergent evolusjon hver gang de ikke kan forklare to lignende trekk ut fra avstamning. Eks. på såkalt konvergens finnes t.o.m. blant medlemmer av ulike taksonomiske rekker (phyla). Vi skal se på noen få eks. på såkalt 'konvergent evolusjon'.

Hvordan kan det ha seg at 'konvergent evolusjon' spiller en så viktig rolle i evolusjon, når variasjon fra tilfeldige kopieringsfeil, viser seg umulig å forekomme i praksis. Evolusjonister påkaller konvergent evolusjon hver gang de ikke kan forklare to lignende trekk ut fra avstamning. Eks. på såkalt konvergens finnes t.o.m. blant medlemmer av ulike taksonomiske rekker (phyla). Vi skal se på noen få eks. på såkalt 'konvergent evolusjon'.

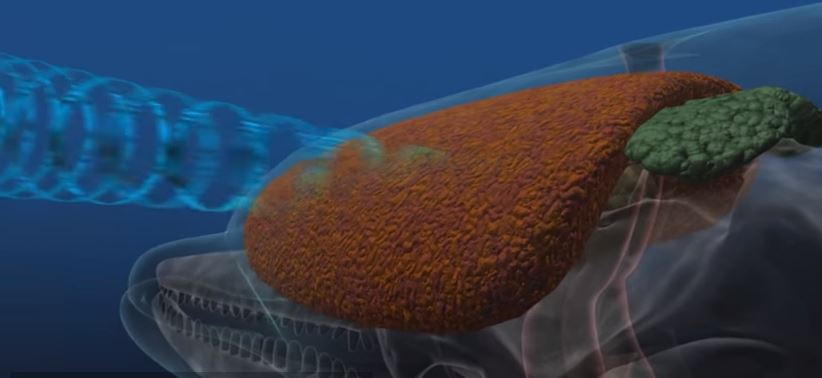

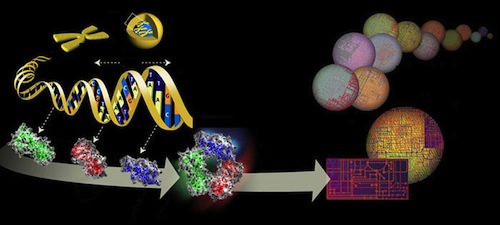

Bilde 10. Sonar hos delfin

Ett forbløffende eks. er ekkolokaliserings-systemet som finnes i dyr spredt i rekken av virveldyr. I sofistikert virkemåte overgår de de mest avanserte militære systemer. Flaggermus har et ekkolokaliseringssystem, og det her også tannhvaler og delfiner. Også noen fugler har det. I følge ekspertene kunne ikke disse ha utviklet seg fra felles opphav. Alle eksperter er enige i at disse systemene utviklet seg i hver av disse gruppene uavhengig av hverandre. (The Design of Life) Noen fisk dreper byttet sitt ved å gi dem elektrisk støt. Høyspennings generatorer for å drepe bytte er funnet i elektrisk ål, skate og steinbit. Disse mener man har utviklet seg uavhengig (Hubbs, 1967).

Det mest forbløffende eks. på såkalt 'konvergent evolusjon' er synet. I tre dyrerekker er det bildeformende øyne. Ett av disse er virveldyrenes, hvor menneskets øye er et typisk eksempel. Om øyet utviklet seg i følge NDT, så må det ha dukket opp i de første virveldyrene, som har en estimert alder på ca. en halv milliard år. Det andre systemet er å finne i bløtdyr (moluscs), hvor f.eks. blekksprutens øyne er slike. I leddyr-rekken har insekter, edderkopper og krabber bildeformende øyne. Inntil 1990-tallet holdt biologer fast ved at øyne hadde utviklet seg uavhengig ca. 30 ganger (Zuker, 1994).

På midten av 1990-tallet ble det rapportert en slående likhet mellom ettt insekt gen og ett virveldyr gen (Quiring et al, 1994) Dette genet er funnet å kontrollere øyets utvikling både hos insekter og virveldyr. Genet i disse to rekkene er 94% identisk. Dette funnet gjør at forfatterne av den artikkelen foreslår at 'det tradisjonelle synet at øyet hos virveldyr og insekter har utviklet seg uavhengig, må revurderes'. Men å forestille seg at det finnes noe alternativ til uavhengig eller konvergent evolusjon, er man ikke åpen for. Men vi kommer tilbake til det senere.

Det mest forbløffende eks. på såkalt 'konvergent evolusjon' er synet. I tre dyrerekker er det bildeformende øyne. Ett av disse er virveldyrenes, hvor menneskets øye er et typisk eksempel. Om øyet utviklet seg i følge NDT, så må det ha dukket opp i de første virveldyrene, som har en estimert alder på ca. en halv milliard år. Det andre systemet er å finne i bløtdyr (moluscs), hvor f.eks. blekksprutens øyne er slike. I leddyr-rekken har insekter, edderkopper og krabber bildeformende øyne. Inntil 1990-tallet holdt biologer fast ved at øyne hadde utviklet seg uavhengig ca. 30 ganger (Zuker, 1994).

På midten av 1990-tallet ble det rapportert en slående likhet mellom ettt insekt gen og ett virveldyr gen (Quiring et al, 1994) Dette genet er funnet å kontrollere øyets utvikling både hos insekter og virveldyr. Genet i disse to rekkene er 94% identisk. Dette funnet gjør at forfatterne av den artikkelen foreslår at 'det tradisjonelle synet at øyet hos virveldyr og insekter har utviklet seg uavhengig, må revurderes'. Men å forestille seg at det finnes noe alternativ til uavhengig eller konvergent evolusjon, er man ikke åpen for. Men vi kommer tilbake til det senere.

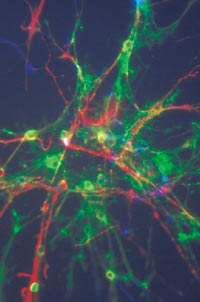

Den menneskelige hjerne er antagelig det mest komplekse objekt i universet (Fischbach, 1992). Noen vil ha det til at den skal ha utviklet seg fra den mye mindre fiskehjernen. Hjerne hos fisker , amfibier og krypdyr er mindre og korteks er glattere enn hos pattedyr. Selv blant pattedyr varierer hjerneformen mye. Fra studier av fossile hodeskaller har paleontologer konkludert at pattedyr-hjernen har utviklet seg parallelt i ulike ordener og familier hos pattedyr. De holder altså på at det mest komplekse organ har utviklet seg via tilfeldige variasjoner atskillige ganger!

Bilde 11. Stamceller i hjernen

Når evolusjonister påkaller konvergens, må de se bort fra darwinistisk forutsetning 2, som sier at i genomet til enhver organisme er det alltid en stor mengde nukleotider der endringer kan tilpasse seg (positiv selektiv verdi). Påstand om konvergent evolusjon står i motstrid til dette, ettersom det fører til umuligheter statistisk sett.

Ett eks. som ble oppdaget på 1990-tallet, var enzymet lysozym, som ble funnet både i ku og en trelevende ape (langur). Lysozyme er ett enzym som er funnet i magen på drøvtyggere. Magen hos langur-apen, som er primat og ikke drøvtygger, er lik det hos drøvtyggere. Neo-darwinister har da hevdet at evolusjon av disse dyrene må ha vært konvergent, siden de produserer så like mager. I framre del av magen hos begge disse dyrene, er det ett gjæringskammer for kjemisk nedbryting. Begge dyreslag benytter bakterier for å bryte ned cellulose. Dyrene overlater jobben med å bryte ned cellulose til bakteriene de har i gjæringskammeret. Bakteriene spiser og fordøyer cellulosen i løv og gress, så overfører dyrene bakteriene til en bakre avdeling i magen, og fordøyer dem. Lysozym bryter ned celleveggen hos bakteriene og tillater dyret å fordøye næringsstoffene i bakteriene.

En gruppe ved Berkeley analyserte sekvensering av aminosyrer i mage-lysozymet hos mennesker bavian, rotte, hest, ku og langur. De konkluderte at 7 aminosyrer har konvergert hos ku og langur (Stewart et al, 1987). Konvergens hos lysozym er i tillegg til konvergens av magens anatomi. Aminosyrene kan bli oversatt tilbake til DNA-nukleotider, der en tar hensyn til redundans i kodingen. Det viser seg at ikke mindre enn ni nukleotider måtte mutere for å endre disse 7 aminosyrene. Om lysozym hos ku og langur-ape virkelig konvergerte, kunne det ikke skje på mindre enn ni steg. Endring av hver nukleotide ville ta minimum ett steg. Hver av dem måtte ha en selektiv fordel. Hvert måtte også være heldig nok til å overleve muligheten for utryddelse og spre seg gjennom populasjonen.

For å vende tilbake til den 2. darwinistiske forutsetningen at i hvert steg, så kunne hvilken som helst av en million genetiske mutasjoner inntreffe. Det samme gjelder som for hestens utvikling. OM NDT skal fungere, må måtte de ta samme vei gjennom labyrinten. Ved hvert av de 9 stegene, måtte samme valget tas mellom en million muligheter. Oddssen for at alle ni er de samme, blir:  eller

eller  . Dette gjelder bare for lysozym enzymet. Sjansen for konvergens når det gjelder magen, skulle bli enda mindre. For at begge skulle inntreffe i en tilfeldig sammenheng, måtte vi ta produktet av dem. Noe som gir:

. Dette gjelder bare for lysozym enzymet. Sjansen for konvergens når det gjelder magen, skulle bli enda mindre. For at begge skulle inntreffe i en tilfeldig sammenheng, måtte vi ta produktet av dem. Noe som gir:  . Oddsen er høyere enn antall elementærpartikler i hele universet.

. Oddsen er høyere enn antall elementærpartikler i hele universet.

Noen evolusjonister hevder at en må vente på at den rette mutasjon må inntreffe, akkurat når den trengs. En nyttig sådan kan være lagret i populasjonen. Men det innebærer at et stort antall unyttige mutasjoner måtte lagres, i tilfelle det skulle bli bruk for den. Vi har tidligere gjort beregninger for hva som kreves for å komme over en nedre grense for hva som trengs. Og beregninger viser igjen (Not By Chance, s.118-119) at det ville forutsette helt eventyrlig antall potensielle rekombinasjoner som var tilpasningsdyktige. Vi fant ved hestens evolusjon at det ikke kunne være konvergens, når det var en million potensielle adaptive mutasjoner. Da kan det enda mindre være det ved slike enorme antall:

Noen evolusjonister hevder at en må vente på at den rette mutasjon må inntreffe, akkurat når den trengs. En nyttig sådan kan være lagret i populasjonen. Men det innebærer at et stort antall unyttige mutasjoner måtte lagres, i tilfelle det skulle bli bruk for den. Vi har tidligere gjort beregninger for hva som kreves for å komme over en nedre grense for hva som trengs. Og beregninger viser igjen (Not By Chance, s.118-119) at det ville forutsette helt eventyrlig antall potensielle rekombinasjoner som var tilpasningsdyktige. Vi fant ved hestens evolusjon at det ikke kunne være konvergens, når det var en million potensielle adaptive mutasjoner. Da kan det enda mindre være det ved slike enorme antall:  som det her er snakk om.

som det her er snakk om.

Genetiske rearrangeringer mangler som vi har sett, evnen til å bygge opp nødvendig informasjon. Den ligger da i prinsippet implisitt til stede i genomet allerede. Dessuten synes ikke Genetiske rearrangeringer å være tilfeldige. NDT hevder det samme som Darwin. Den hevder å forklare hvordan livet utviklet seg fra en 'enkel' begynnelse. Den hevder å forklare hvordan all alt komplekst liv utviklet seg gjennom en prosess som inntreffer gjennom en kombinasjon av tilfeldighet og kjente lover i naturen. Den hevder også at den har erstattet design med sjanse/ tilfeldighet.

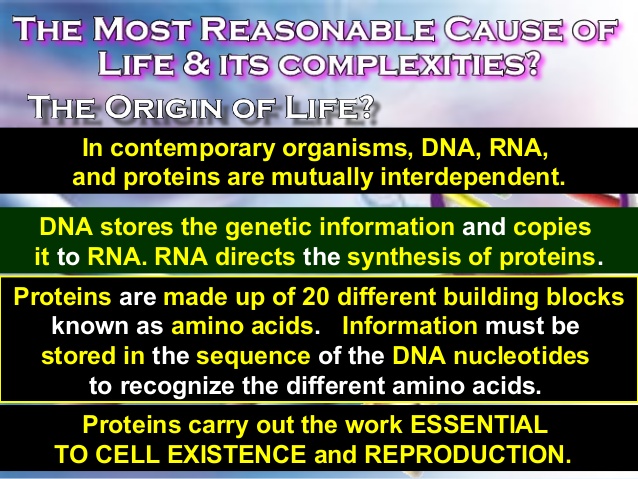

Bilde 12. Menneskelig genom (US: billion tilsvarer no: milliarder)

Men vi har sett at kopieringsfeil, selv om de er lagret som potensielle rekombinasjoner, ikke kan gi den tilfeldige variasjonen som behøves i NDT. Om kopieringsfeil utgjør variasjonen i NDT, så forutsier teorien at viktige begivenheter i evolusjonen er nesten umulige. Da kan en ikke rettmessig hevde at teorien forklarer disse begivenhetene. Konsekvensen av å anvende NDT blir en statistisk umulighet, noe som burde være alvorlig i en teori avhengig av tilfeldigheter. Mange biologer er skeptiske til at små mutasjoner har kraft til å oppnå makroevolusjon (Ho og Saunders, 1979). Vi har nå sett på hvorfor en burde være skeptisk.

Stoffutvalg og bilder ved Asbjørn E. Lund

.

Tilhengere av sprangvis evolusjon hevder at makroevolusjonære endringer oftere er en enkelt stor tilfeldig endring enn en serie av små. De sier at store endringer i fenotypen hovedsakelig kommer fra endringer i regulerende gener. John Mc Donald (1990) er tilhenger av innsetting av DNA-segmenter (RLEs -Retroviral Like Elements). RLes er lik ombyttbare elementer, som likner såkalte retrovirus (Hos retrovirus går den første delen av syntesen fra RNA til DNA, dvs. den “bakvendte veien”, derav navnet.) Når det kommer inn i en celle kopierer det sin RNA til DNA med et medfølgende enzym det bærer med seg (reverse transcriptase). Så skjer en repetisjon hvor DNA kopieres til den andre DNA-delen ved hjelp av samme enzym. Så benyttes et hittil ukjent enzym til å sette inn denne DNA-sekvensen i cellens genom. Hvert steg kontrolleres av spesielle enzymer.

Tilhengere av sprangvis evolusjon hevder at makroevolusjonære endringer oftere er en enkelt stor tilfeldig endring enn en serie av små. De sier at store endringer i fenotypen hovedsakelig kommer fra endringer i regulerende gener. John Mc Donald (1990) er tilhenger av innsetting av DNA-segmenter (RLEs -Retroviral Like Elements). RLes er lik ombyttbare elementer, som likner såkalte retrovirus (Hos retrovirus går den første delen av syntesen fra RNA til DNA, dvs. den “bakvendte veien”, derav navnet.) Når det kommer inn i en celle kopierer det sin RNA til DNA med et medfølgende enzym det bærer med seg (reverse transcriptase). Så skjer en repetisjon hvor DNA kopieres til den andre DNA-delen ved hjelp av samme enzym. Så benyttes et hittil ukjent enzym til å sette inn denne DNA-sekvensen i cellens genom. Hvert steg kontrolleres av spesielle enzymer.  Innsettinger og inversjoner kan deaktivere genet som de entrer ved å ødelegge lese-rammen. De fungerer dermed som brytere for å slå av ett gen. Innsettingssekvensene har spesielle indikatorer på endene, som identifiserer dem for fjerning og ombytting. Om det ikke var for presisjonen de virket med, ville de slå gener av og på tilfeldig og forsårsake ødeleggelse i genomet. Om det ikke var for spesielle indikatorer på endene av innsettings-sekvensene, så ville det være liten sjanse for å slå på igjen deaktiverte gener. Sjansen for at en tilfeldig sletting nøyaktig fjerner en tidligere innsetting, er meget liten:

Innsettinger og inversjoner kan deaktivere genet som de entrer ved å ødelegge lese-rammen. De fungerer dermed som brytere for å slå av ett gen. Innsettingssekvensene har spesielle indikatorer på endene, som identifiserer dem for fjerning og ombytting. Om det ikke var for presisjonen de virket med, ville de slå gener av og på tilfeldig og forsårsake ødeleggelse i genomet. Om det ikke var for spesielle indikatorer på endene av innsettings-sekvensene, så ville det være liten sjanse for å slå på igjen deaktiverte gener. Sjansen for at en tilfeldig sletting nøyaktig fjerner en tidligere innsetting, er meget liten:  Sjansen er også liten for at en tilfeldig innsetting nøyaktig skal reversere en tidligere innsetting. Sjansen for at en ombytting vil inntreffe i et bakterie-genom, er ca 1 på en million generasjoner (Stryer, 1988). Om de er tilfeldige, ville det være like sannsynlig å inntreffe overalt i genomet. Dermed ville sjansen for at en innsetting eller inversjon ville ha sitt endepunkt på akkurat én nukleotide, være 1 millionte-del av 1 million, eller 1 billionte-del. I bakterier er mutasjoner hyppige nok til at det vil kunne inntreffe, men gjennom hele hestens evolusjonsforløp (anslått til ca. 65 millioner år), så har det vært ca. 1 billion replikasjoner (Simpson, 1953), og det gjelder for samtlige slags hester.

Sjansen er også liten for at en tilfeldig innsetting nøyaktig skal reversere en tidligere innsetting. Sjansen for at en ombytting vil inntreffe i et bakterie-genom, er ca 1 på en million generasjoner (Stryer, 1988). Om de er tilfeldige, ville det være like sannsynlig å inntreffe overalt i genomet. Dermed ville sjansen for at en innsetting eller inversjon ville ha sitt endepunkt på akkurat én nukleotide, være 1 millionte-del av 1 million, eller 1 billionte-del. I bakterier er mutasjoner hyppige nok til at det vil kunne inntreffe, men gjennom hele hestens evolusjonsforløp (anslått til ca. 65 millioner år), så har det vært ca. 1 billion replikasjoner (Simpson, 1953), og det gjelder for samtlige slags hester. Feilratene er såpass små fordi cellene har en feillesnings-mekanisme som korrigerer flesteparten av feilene gjort i transkripsjon. Evolusjonister sier denne mekanismen utviklet seg, men den ville ikke ha utviklet seg om den ikke var nødvendig. Feilretting holder feilraten lav nok til at de ikke ødelegger et genom som allerede fungerer bra. Lubert Stryer ved stanford universitet hevder at mutasjonsraten er blitt optiamlisert. Han sier: "mutasjonsraten er blitt optimalisert.. En for høy rate ville føre til ikke-levelig avkom, mens en for lav rate ville forminske genetisk mangfold" (Stryer, 1988, s.676)

Feilratene er såpass små fordi cellene har en feillesnings-mekanisme som korrigerer flesteparten av feilene gjort i transkripsjon. Evolusjonister sier denne mekanismen utviklet seg, men den ville ikke ha utviklet seg om den ikke var nødvendig. Feilretting holder feilraten lav nok til at de ikke ødelegger et genom som allerede fungerer bra. Lubert Stryer ved stanford universitet hevder at mutasjonsraten er blitt optiamlisert. Han sier: "mutasjonsraten er blitt optimalisert.. En for høy rate ville føre til ikke-levelig avkom, mens en for lav rate ville forminske genetisk mangfold" (Stryer, 1988, s.676) Vi ønsker å sette en fornuftig sjanse for at NDT skal fungere. Desto høyere vi setter sannsynligheten, desto vanskeligere vil det være for evolusjon å fungere og vice versa. Richard Lewontin fra Harvard universitet har estimert at for hver nålevende rase, så er det 1000 som er utdødd. Vil 1/1000 være et rimelig estimat for sjansen til å få en ny art? På en side, kanskje den skulle være større: Noen av de utdødde rasene, uvisst hvor mange, er ikke uten levende etterkommere. På den annen side er det nålevende raser i dag, som ikke har utviklet seg på millioner av år (krokodiller, flaggermus m.m). Dette kalles det såkalte stasis-paradokset, som tilhengere av sprangvis evolusjon (punktualister) har bemerket. Det kan tyde på at faktoren er mindre enn 1 tusendel, vi setter en nedre skranke på 1 millionte-del.

Vi ønsker å sette en fornuftig sjanse for at NDT skal fungere. Desto høyere vi setter sannsynligheten, desto vanskeligere vil det være for evolusjon å fungere og vice versa. Richard Lewontin fra Harvard universitet har estimert at for hver nålevende rase, så er det 1000 som er utdødd. Vil 1/1000 være et rimelig estimat for sjansen til å få en ny art? På en side, kanskje den skulle være større: Noen av de utdødde rasene, uvisst hvor mange, er ikke uten levende etterkommere. På den annen side er det nålevende raser i dag, som ikke har utviklet seg på millioner av år (krokodiller, flaggermus m.m). Dette kalles det såkalte stasis-paradokset, som tilhengere av sprangvis evolusjon (punktualister) har bemerket. Det kan tyde på at faktoren er mindre enn 1 tusendel, vi setter en nedre skranke på 1 millionte-del. Mutasjonen som leder til forbedringen må også være dominant. Det innebærer at mutasjonen uttrykkes i fenotypen, selv om det bare er en av to kromosomene som bærer genet. Om den måtte vært på begge kromosomer for å uttrykkes (recessiv), så ville sannsynligheten vært MYE mindre. Siden denne type mutasjoner er de minst tenkelige, så vil også selektiv verdi være liten. Fishers analyse viser at en mutant med en selektiv verdi på 1%, vil ha en sjanse på 2% for å overleve i en populasjon (større enn 10.000). Tilsvarende om den selektive verdien var 0,1% så ville sjansen for å overleve være 0,2% (1:500). Om selektiv verdi er 0,01%, så ville sjansen for å overleve være 0,02% eller (1:5000).

Mutasjonen som leder til forbedringen må også være dominant. Det innebærer at mutasjonen uttrykkes i fenotypen, selv om det bare er en av to kromosomene som bærer genet. Om den måtte vært på begge kromosomer for å uttrykkes (recessiv), så ville sannsynligheten vært MYE mindre. Siden denne type mutasjoner er de minst tenkelige, så vil også selektiv verdi være liten. Fishers analyse viser at en mutant med en selektiv verdi på 1%, vil ha en sjanse på 2% for å overleve i en populasjon (større enn 10.000). Tilsvarende om den selektive verdien var 0,1% så ville sjansen for å overleve være 0,2% (1:500). Om selektiv verdi er 0,01%, så ville sjansen for å overleve være 0,02% eller (1:5000). Vi skal repetere hva som kreves for at å fullføre ett av 500 suksessfylte steg: En mutasjon må inntreffe, og den må overleve for å ta over populasjonen. Men sjansen er liten: Sjansen for at den vil inntreffe ble estimert til 1:600. Med en selektiv verdi på 0,1%, så er sjansen for at mutasjonen skal overleve 1:500. Sjansen for at den både skal dukke opp og overleve er anslagsvis: (1/600)*(1/500) som gir 1:300.00. For at en ny art skal inntreffe, må 500 av disse inntreffe uten å feile. Sjansen for at dette skal skje, blir (1:300.000) opphøyd i 500 som er ca.

Vi skal repetere hva som kreves for at å fullføre ett av 500 suksessfylte steg: En mutasjon må inntreffe, og den må overleve for å ta over populasjonen. Men sjansen er liten: Sjansen for at den vil inntreffe ble estimert til 1:600. Med en selektiv verdi på 0,1%, så er sjansen for at mutasjonen skal overleve 1:500. Sjansen for at den både skal dukke opp og overleve er anslagsvis: (1/600)*(1/500) som gir 1:300.00. For at en ny art skal inntreffe, må 500 av disse inntreffe uten å feile. Sjansen for at dette skal skje, blir (1:300.000) opphøyd i 500 som er ca. Hver av disse 1 million potensielt fordelaktige mutasjonene, må ikke bare være fordelaktige, men må også øke genomets informasjon. Oppsummert blir betingelsene:

Hver av disse 1 million potensielt fordelaktige mutasjonene, må ikke bare være fordelaktige, men må også øke genomets informasjon. Oppsummert blir betingelsene:  Ingen mutasjoner som har (positiv) selektiv verdi, er kjent for å tilfredsstille denne betingelsen. Enten reduserer de informasjonen i genomet, eller de øker den så mye at det er snakk om mutasjoner som slår på informasjon som allerede er i genomet (lenke). Noen former for mikroevolusjon involverer ikke mutasjoner. I stedet benyttes allerede eksisterende variasjon i populasjonen. Nevnte eks. med industriell melanisme av nattsommerfugler, er et slikt eks. Både lyse og mørke nattsommerfugler har eksistert side om side i populasjonen. Men disse er forholdsvis få i antall, og kan ikke være en lang rekke av genvarianter, som venter på å bli kalt i aksjon. Derfor kan ikke industriell melanisme tjene som et typisk eksempel på ett av stegene i kumulativ seleksjon.

Ingen mutasjoner som har (positiv) selektiv verdi, er kjent for å tilfredsstille denne betingelsen. Enten reduserer de informasjonen i genomet, eller de øker den så mye at det er snakk om mutasjoner som slår på informasjon som allerede er i genomet (lenke). Noen former for mikroevolusjon involverer ikke mutasjoner. I stedet benyttes allerede eksisterende variasjon i populasjonen. Nevnte eks. med industriell melanisme av nattsommerfugler, er et slikt eks. Både lyse og mørke nattsommerfugler har eksistert side om side i populasjonen. Men disse er forholdsvis få i antall, og kan ikke være en lang rekke av genvarianter, som venter på å bli kalt i aksjon. Derfor kan ikke industriell melanisme tjene som et typisk eksempel på ett av stegene i kumulativ seleksjon. Det er blitt påpekt av evolusjonistiske forskere, at en i hvert av de 500 steg som leder til en ny art, må tenke på fenotyper (hvordan de framtrer) i stedet for genotyper (gensammensetning). Dermed reduserer vi raust kravet fra at det må gjelde 1 million genotyper, til at det dreier seg om ca. 1.000 ulike fenotyper. På hvert steg er det altså 1.000 muligheter for at en endring kan skje. Oddsen mot at samme endring skal inntreffe to ganger er 1.000 mot én. For at den skal inntreffe 500 ganger er oddsen:

Det er blitt påpekt av evolusjonistiske forskere, at en i hvert av de 500 steg som leder til en ny art, må tenke på fenotyper (hvordan de framtrer) i stedet for genotyper (gensammensetning). Dermed reduserer vi raust kravet fra at det må gjelde 1 million genotyper, til at det dreier seg om ca. 1.000 ulike fenotyper. På hvert steg er det altså 1.000 muligheter for at en endring kan skje. Oddsen mot at samme endring skal inntreffe to ganger er 1.000 mot én. For at den skal inntreffe 500 ganger er oddsen:  Hvordan kan det ha seg at 'konvergent evolusjon' spiller en så viktig rolle i evolusjon, når variasjon fra tilfeldige kopieringsfeil, viser seg umulig å forekomme i praksis. Evolusjonister påkaller konvergent evolusjon hver gang de ikke kan forklare to lignende trekk ut fra avstamning. Eks. på såkalt konvergens finnes t.o.m. blant medlemmer av ulike taksonomiske rekker (phyla). Vi skal se på noen få eks. på såkalt 'konvergent evolusjon'.

Hvordan kan det ha seg at 'konvergent evolusjon' spiller en så viktig rolle i evolusjon, når variasjon fra tilfeldige kopieringsfeil, viser seg umulig å forekomme i praksis. Evolusjonister påkaller konvergent evolusjon hver gang de ikke kan forklare to lignende trekk ut fra avstamning. Eks. på såkalt konvergens finnes t.o.m. blant medlemmer av ulike taksonomiske rekker (phyla). Vi skal se på noen få eks. på såkalt 'konvergent evolusjon'. Det mest forbløffende eks. på såkalt 'konvergent evolusjon' er synet. I tre dyrerekker er det bildeformende øyne. Ett av disse er virveldyrenes, hvor menneskets øye er et typisk eksempel. Om øyet utviklet seg i følge NDT, så må det ha dukket opp i de første virveldyrene, som har en estimert alder på ca. en halv milliard år. Det andre systemet er å finne i bløtdyr (moluscs), hvor f.eks. blekksprutens øyne er slike. I leddyr-rekken har insekter, edderkopper og krabber bildeformende øyne. Inntil 1990-tallet holdt biologer fast ved at øyne hadde utviklet seg uavhengig ca. 30 ganger (

Det mest forbløffende eks. på såkalt 'konvergent evolusjon' er synet. I tre dyrerekker er det bildeformende øyne. Ett av disse er virveldyrenes, hvor menneskets øye er et typisk eksempel. Om øyet utviklet seg i følge NDT, så må det ha dukket opp i de første virveldyrene, som har en estimert alder på ca. en halv milliard år. Det andre systemet er å finne i bløtdyr (moluscs), hvor f.eks. blekksprutens øyne er slike. I leddyr-rekken har insekter, edderkopper og krabber bildeformende øyne. Inntil 1990-tallet holdt biologer fast ved at øyne hadde utviklet seg uavhengig ca. 30 ganger ( Noen evolusjonister hevder at en må vente på at den rette mutasjon må inntreffe, akkurat når den trengs. En nyttig sådan kan være lagret i populasjonen. Men det innebærer at et stort antall unyttige mutasjoner måtte lagres, i tilfelle det skulle bli bruk for den. Vi har tidligere gjort beregninger for hva som kreves for å komme over en nedre grense for hva som trengs. Og beregninger viser igjen (Not By Chance, s.118-119) at det ville forutsette helt eventyrlig antall potensielle rekombinasjoner som var tilpasningsdyktige. Vi fant ved hestens evolusjon at det ikke kunne være konvergens, når det var en million potensielle adaptive mutasjoner. Da kan det enda mindre være det ved slike enorme antall:

Noen evolusjonister hevder at en må vente på at den rette mutasjon må inntreffe, akkurat når den trengs. En nyttig sådan kan være lagret i populasjonen. Men det innebærer at et stort antall unyttige mutasjoner måtte lagres, i tilfelle det skulle bli bruk for den. Vi har tidligere gjort beregninger for hva som kreves for å komme over en nedre grense for hva som trengs. Og beregninger viser igjen (Not By Chance, s.118-119) at det ville forutsette helt eventyrlig antall potensielle rekombinasjoner som var tilpasningsdyktige. Vi fant ved hestens evolusjon at det ikke kunne være konvergens, når det var en million potensielle adaptive mutasjoner. Da kan det enda mindre være det ved slike enorme antall: